Siempre digo que The Good Fight es la serie actual que mejor habla de la «realidad». Aunque es una serie de ficción, muchas de sus tramas se basan en historias que podemos reconocer de las noticias. Como es una serie de EE. UU., normalmente habla de las circunstancias políticas, sociales y económicas de ese país, pero la mayoría son similares a las de cualquier otro país capitalista.

Aparte del cine, o del audiovisual en general, me interesan mucho las nuevas tecnologías, así que siempre me hacen gracia los episodios que tratan temas relacionados con Internet, los algoritmos, etc. Últimamente, he leído varios libros sobre el sesgo algorítmico y uno de ellos, Weapons of Math Destruction de Cathy O’Neil, habla precisamente de un caso tratado en The Good Fight.

El sesgo algorítmico

Por si no estáis familiarizados con el término «sesgo algorítmico», voy a empezar explicando qué es. Un sesgo algorítmico es cuando un sistema informático genera un resultado injusto. Por ejemplo, dar prioridad a un hombre sobre una mujer o a un blanco sobre un negro.

Para entenderlo mejor, voy a explicar la historia de lo que sucede en el episodio en cuestión (el 4 de la temporada 2). Si habéis visto la serie, recordaréis enseguida de qué episodio hablo. Liz Reddick va a llevar a su hijo al colegio y se encuentra con que están echando a Mr. Coulson, el profesor preferido del niño. Ella se extraña y llama a la directora para saber qué ha pasado. Aunque no le explica gran cosa, se entera de que el profesor va a reclamar. Como ella es abogada, decide ayudarlo.

Lo primero que piensa Liz es que se trata de un problema de racismo u homofobia, porque Mr. Coulson es negro y gay. No obstante, en el arbitraje, la directora les explica enseguida que echan a los profesores en base a su rendimiento. ¿Y cómo se calcula su rendimiento?

Efectivamente, con un algoritmo. Los algoritmos son lógicos y matemáticos, y eso es lo que necesitan para echar a gente sin sesgos ni prejuicios. El problema es que no es verdad que los algoritmos no tengan sesgos ni prejuicios. Para empezar, para que un algoritmo sea justo tiene que estar basado en datos correctos e imparciales.

Esta historia viene de un caso real que sucedió en EE. UU. y que se explica en el libro que mencionaba al comienzo de este texto. En 2007, en Washington, D. C., se propusieron buscar una manera de que los colegios publicos mejorasen la calidad de su educación. Decidieron que si los niños no aprendían era culpa de los profesores y profesoras, así que había que buscar una manera de medir su rendimiento.

Con este objetivo en mente, crearon una herramienta para evaluar a los maestros y maestras. La herramienta les asignaba una puntuación después de valorar una serie de datos, y si esa puntuación no pasaba de cierta cifra perdían su trabajo. En principio, la idea no era mala, es obvio que muchas veces se echa antes a alguien que hace bien su trabajo que a alguien que no por muchas razones, principalmente nepotismo, así que eliminar el factor humano en cierto tipo de decisiones podría evitar favoritismos. Lo que pasa es que las cosas no son tan simples…

Entre todas esas personas a las que despidieron, había una profesora llamada Sarah Wysocki. Sarah, como Mr. Coulson, era una profesora muy bien valorada, nunca había tenido ningún problema en su trabajo y quiso saber por qué la estaban echando. Investigando un poco, consiguió averiguar que el sistema de evaluación había sido desarrollado por una consultoría privada.

La queja de Sarah no fue un caso aislado, muchas personas que trabajaban en la enseñanza se quejaron durante años. Lo máximo que conseguían averiguar es que los había echado un algoritmo con muchas variables, y la mayoría se iban rindiendo porque les intimidaba la complejidad matemática del tema.

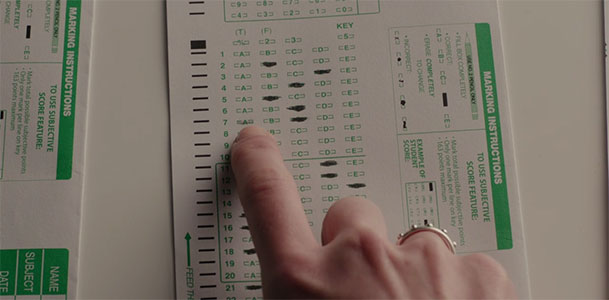

En The Good Fight, explican que uno de los principales problemas es que los algoritmos se basan en datos, y los datos pueden ser subjetivos y estar abiertos a la interpretación. Además, revisando las pruebas del caso se dan cuenta de que muchas de las hojas de respuesta de los exámenes de clase tienen cosas borradas.

Aunque es normal borrar cosas en un examen y volver a escribirlas, sospechan que algo raro hay detrás porque los alumnos y alumnas sacan mejores notas con profesores/as que no les gustan.

Sarah, la profesora real que sufrió esta historia, sospechó por otras razones. En su caso, le extrañó que alumnos que venían de otros colegios con notas fantásticas y que supuestamente sabían leer y escribir no fuesen capaces de leer frases sencillas.

La cuestión, en ambos casos, es que algunos profesores y profesoras corregían las respuestas de los niños y niñas para que tuviesen notas más altas, así conseguían que el algoritmo pensase que su rendimiento era mejor. Es decir, el algoritmo estaba despidiendo a quien era bueno y honesto y dando un trato de favor a quien mentía.

Tanto en la serie como en la vida real hay otra vuelta de tuerca final. Mr. Coulson recupera su trabajo, pero justo antes le ofrecen un trabajo mejor pagado en un colegio privado. Eso fue lo que pasó realmente con Sarah, le ofrecieron un puesto mejor pagado en un colegio privado y abandonó la escuela pública.

La conclusión de Cathy O’Neil en su libro es que «gracias a un modelo cuestionable, un colegio pobre perdió a una buena profesora, y uno rico (…) la ganó». En este ejemplo, el problema es que los datos en los que se basaba el algoritmo para tomar su decisión no eran fiables, otros sesgos se deben a otras razones.

Este es solo uno de los muchos problemas que podrían provocan, y provocan, los algoritmos, la inteligencia artificial y otros métodos informáticos que ya están gobernando nuestras vidas, aunque en general no seamos conscientes de ellos. Un algoritmo puede provocar que no nos den un puesto de trabajo o un crédito. En algunos países, como EE. UU., ya se están usando algoritmos en el sistema judicial para decidir si conceder o no la libertad condicional, por ejemplo.

El sesgo algorítmico puede generar problemas cotidianos menores, pero también problemas muy graves. Tenemos que ser conscientes de cómo funcionan las cosas.